Baichuan-7B:开源大规模预训练语言模型的新标杆

Baichuan-7B:大规模预开源语言模型的新标杆

在人工智能和自然语言处理领域,大规模预训练语言模型(Large Language Models, LLMs)的发展日新月异。近日,由百川智能开发的开源大模型Baichuan-7B的横空出世,为开源LLMs的发展注入论文将全面介绍百川7B的特点、性能表现以及其在开源LLM领域的重要意义。

百川7B简介

Baichuan-7B是一个基于Transformer架构的大规模预训练语言模型,拥有70亿参数,在约1.2万亿代币的语料上进行训练。该模型支持中英文双语,上下文窗口长度为4096代币。一个开源的可用于的模型,Baichuan-7B在GitHub上发布并提供了完整的模型权重、代码和推理代码。

业绩表现

Baichuan-7B在多个权威的中英文基准测试中表现出同尺寸的最佳性能:

C-Eval测试

C-Eval是一个全面的中文语言模型数学数据集,涵盖52个学科和4个难度级别。在5-shot测试中,Baichuan-7B的平均得分为42.8%,远超其他开源7B模型,甚至接近一些扩大参数量的模型。

高考

在中国高考构建的高考测试集上,Baichuan-7B同样表现出色,得分为36.24%,大幅领先其他同尺寸模型。

AGIEval测试

AGIEval旨在评估模型在认知和问题解决方面的一般能力。Baichuan-7B在此测试中得分34.44%,再次显示出其强大的综合能力。

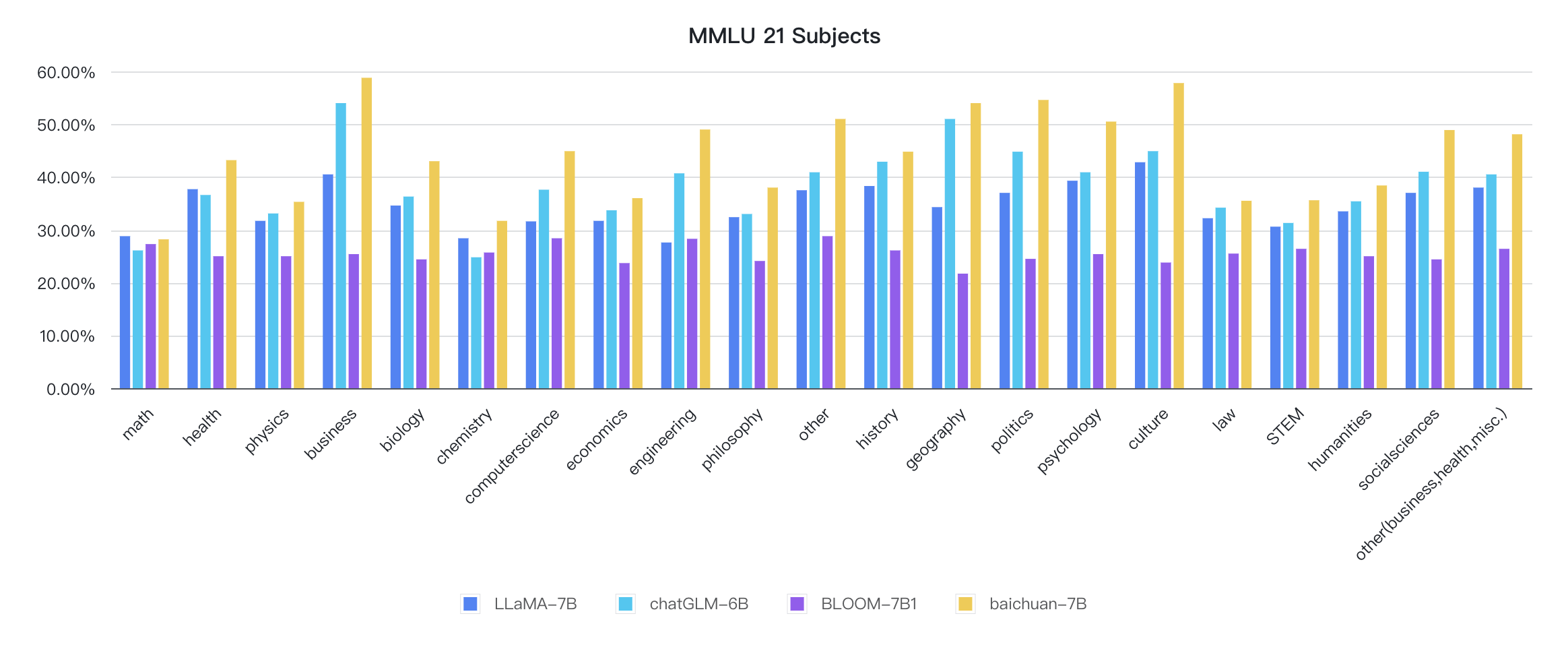

MMLU英语测试

在包含57个多选任务的MMLU中文体育数据集上,百川-7B的平均得分高达42.3%,超越了大众知名中文大模型,表现出了其优秀的跨语言能力。

技术创新与优化

百川七号B的优异表现源于其在多个技术层面的创新与优化:

数据处理

百川团队采用了基于启发式规则和质量模型打分的方法,对原始数据集进行了篇章和句子粒度过滤。同时,采用局部针对敏感分区的方法进行了全量数据的去重,并通过自动学习的数据权重优化策略进行了不同类别数据的配比。

词彙調整

Baichuan-7B采用了经过优化的SentencePiece中的字节对编码(BPE)算法进行分词。通过使用大规模中英文料训练分词模型,对中文的压缩率显着提升。同时,针对它们的数学领域和对罕见问题词进行了特殊处理,提高了模型在这些领域的表现。

结构经济学

Baichuan-7B采用了与LLaMA类似的模型设计,包括使用嵌入旋转作为位置编码、SwiGLU作为激活函数、以及基于RMSNorm的预归一化等。这些优化措施使得模型在保持高性能的同时,具有更好的性能性能的外推能力和训练稳定性。

训练优化

在训练过程中,百川团队采用了实例训练优化技术,包括子优化、算子切分、混合精度达到、容灾以及通信优化等。这些优化使得7B模型在千卡A800算卡上达到了182 TFLOPS的吞吐,GPU最高算力效率高达58.3%。

开源与生态

百川-7B不仅提供开源模型训练本身,还包括完整的推理代码。这为研究人员和开发者提供了宝贵的学习和实践机会。同时,百川团队还积极与社区合作,支持多种第三方资源和工具:

- LLaMA调优:支持使用QLora进行参数,并支持RLHF和WebDemo。

- 多个基于Baichuan-7B模型的模型:如baichuan-vicuna-chinese-7b和baichuan-vicuna-7b等。

- Efficient-Tuning-LLMs:支持使用QLora进行参数和4位推理。

- fastllm:纯C++实现的大模型库,支持Baichuan-7B在手机端运行。

- GPTQ量化版本:提供了针对Baichuan-7B的4bit GPTQ量化。

这些丰富的生态资源极大地拓展了百川7B的应用前景和可能性。

结语

Baichuan-7B的发布无疑为开源大模型领域带来了一股新的力量。其优异的技术、创新和丰富的生态,不仅为研究人员提供了宝贵的学习资源,也为开发者提供了强大的力量我们期待看到更多基于百川-7B的创新应用,以及它在推动自然语言处理技术发展中发挥的重要作用。

随着大模型技术的不断进步,像百川-7B这样的开源项目将在促进技术民主化、推动行业创新方面发挥越来越重要的作用。我们有理由相信,在不久的将来,更多像百川-7B这样优秀的伟大模范将坚定不移,为人工智能的发展注入新的活力。

项目链接:www.dongaigc.com/a/baichuan-7b-open-source-language-model

https://www.dongaigc.com/a/baichuan-7b-open-source-language-model

Comments

Post a Comment